普通のカメラで見える世界

2020年05月08日

学部4年になりました。柴田です。

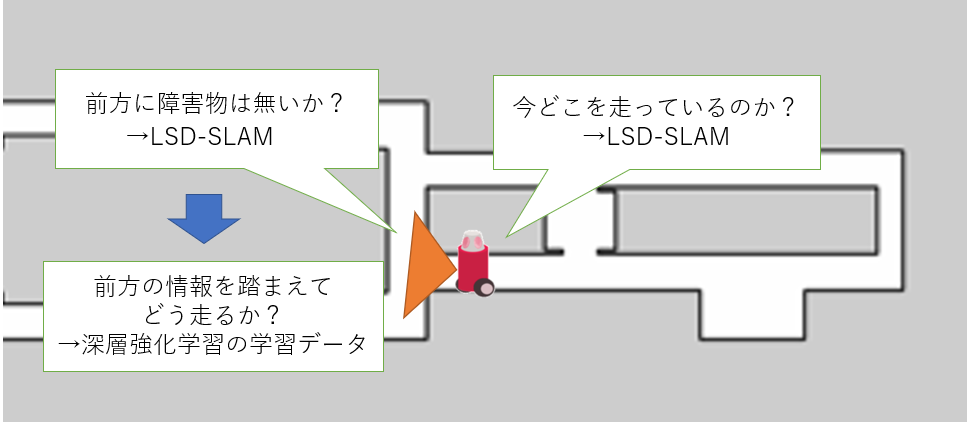

最近はLSD-SLAMというオープンソースのシステムを使い、RGBカメラ画像から自己位置と深度情報を取得し、得られた値をもとに強化学習ベースでロボットを走行させるということを行っています。

LSD-SLAMとは単眼カメラの画像からピクセル間の輝度勾配をもとにカメラの位置、姿勢、向きを求めるvisual slam技術です。こちらで簡単な説明や、githubで自分の環境で実際に試してみることもできます。

さっくり言うと、ロボットの自律走行に必要なデータを普通のカメラ一台で取ってきちゃおうというものです。

さらにざっくり図で説明するとこんな感じ

使用するロボットの外観はこんな感じ

画像ではレーザーセンサも着いていますが今回は使っておらず、上の方についているwebカメラと、ロボット本体とPCだけで走行させます。

とりあえず、深度情報を別の情報で取得し、0.5m走行させた時の自己位置推定結果が以下です。ここでは、カメラから見た前方がz軸、水平右方向にx軸です。

実際は1.3mくらい進みました、、、、 、、あれ、z軸の単位ってなんだ、、、、?

その他にも、もう少し難所が待ち受けていそうですが今日はこの辺で。