RGB-D カメラと三次元地図を活用してカメラ位置姿勢取得を自動化

2024年12月30日

こんにちは。M1の岩﨑です。今回は、先日SI2024で発表した私の研究テーマ「空間知能化における分散RGB-Dカメラの位置・姿勢取得の自動化と人物追跡システムの開発」について紹介します。

背景・目的

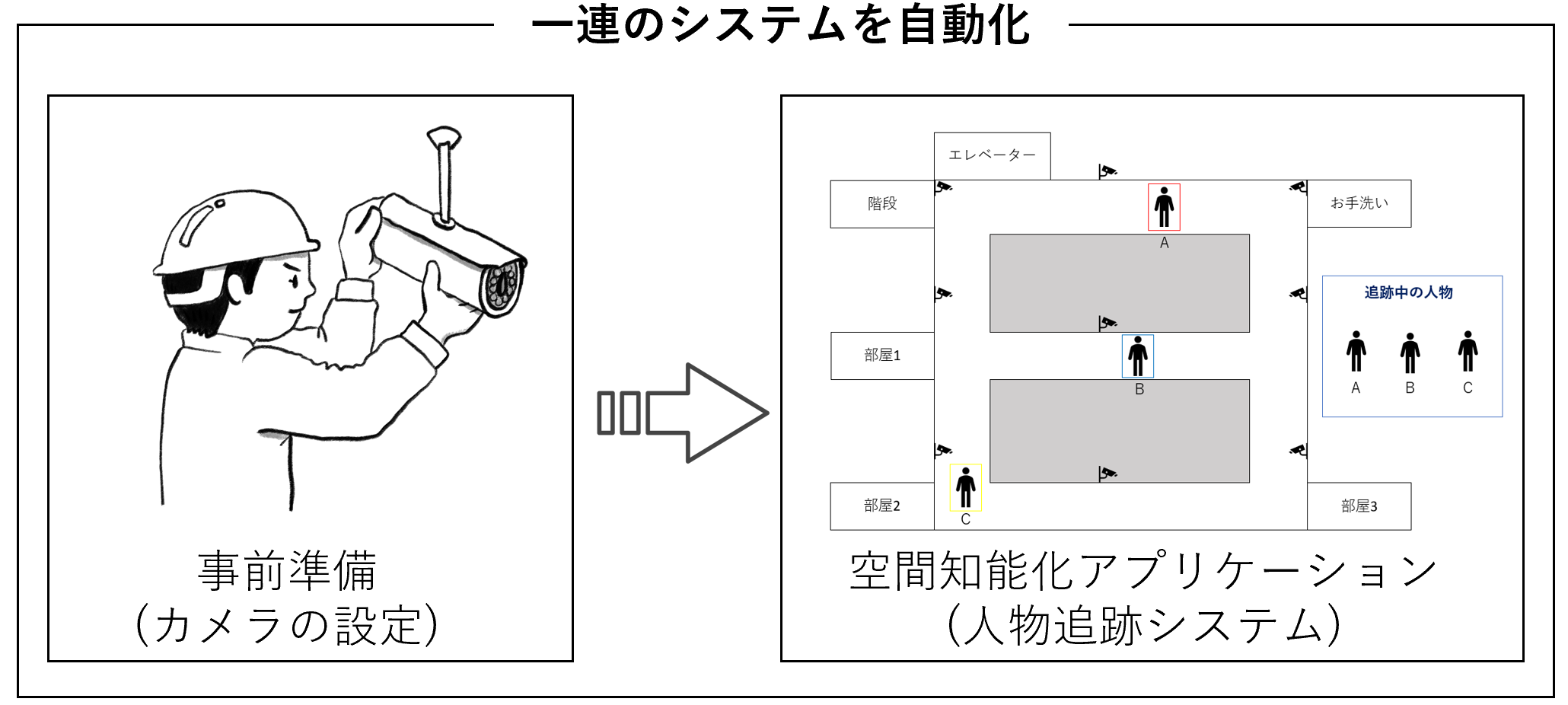

近年、空間知能化システムの重要性が急速に高まり、都市環境や産業現場などでの応用が期待されています。これらのシステムは、空間内の人や物の動きを認識し、精密な環境把握を基に高度な制御やサービスを提供します。これを支える技術として、特に重要な役割を果たすのがカメラを用いた人物追跡です。

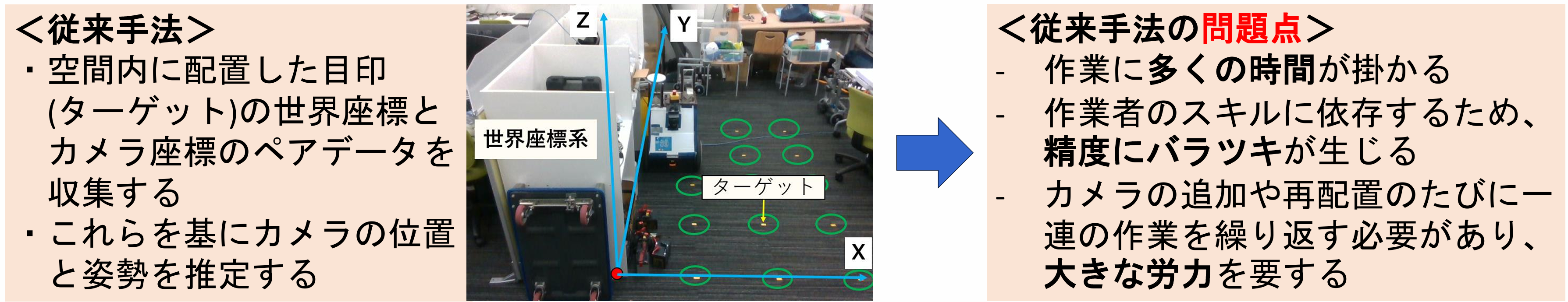

人物追跡を正確に行うには、複数のカメラの位置と姿勢を正確に把握することが不可欠であり、従来は、手動でカメラの位置・姿勢を取得する方法が一般的でしたが、この手法にはいくつかの課題がありました。

そこで本研究では、RGB-Dカメラと三次元地図を活用し、カメラ位置・姿勢の自動取得を実現することで、空間知能化システムの構築~運用までの一連のプロセスを統合・自動化することを目指します。

提案手法

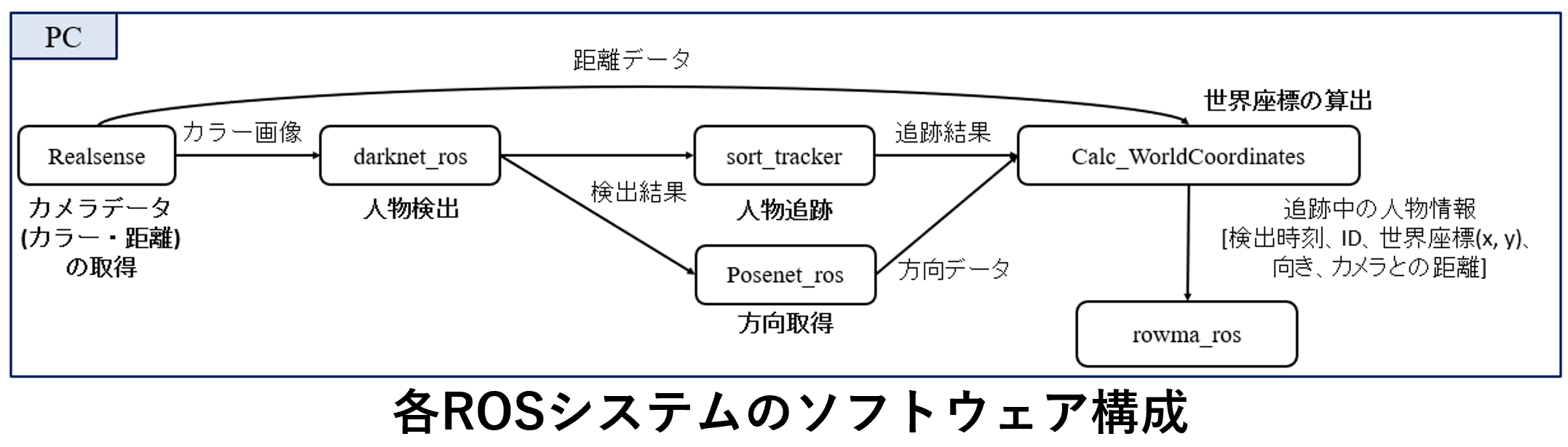

本研究では、RGB-Dカメラで取得した点群データと三次元地図を用いて、カメラの位置・姿勢取得作業の自動化を実現します。具体的な手順は以下の通りです。

1. 三次元地図の作成と分散配置した各RGB-Dカメラ視点の点群取得

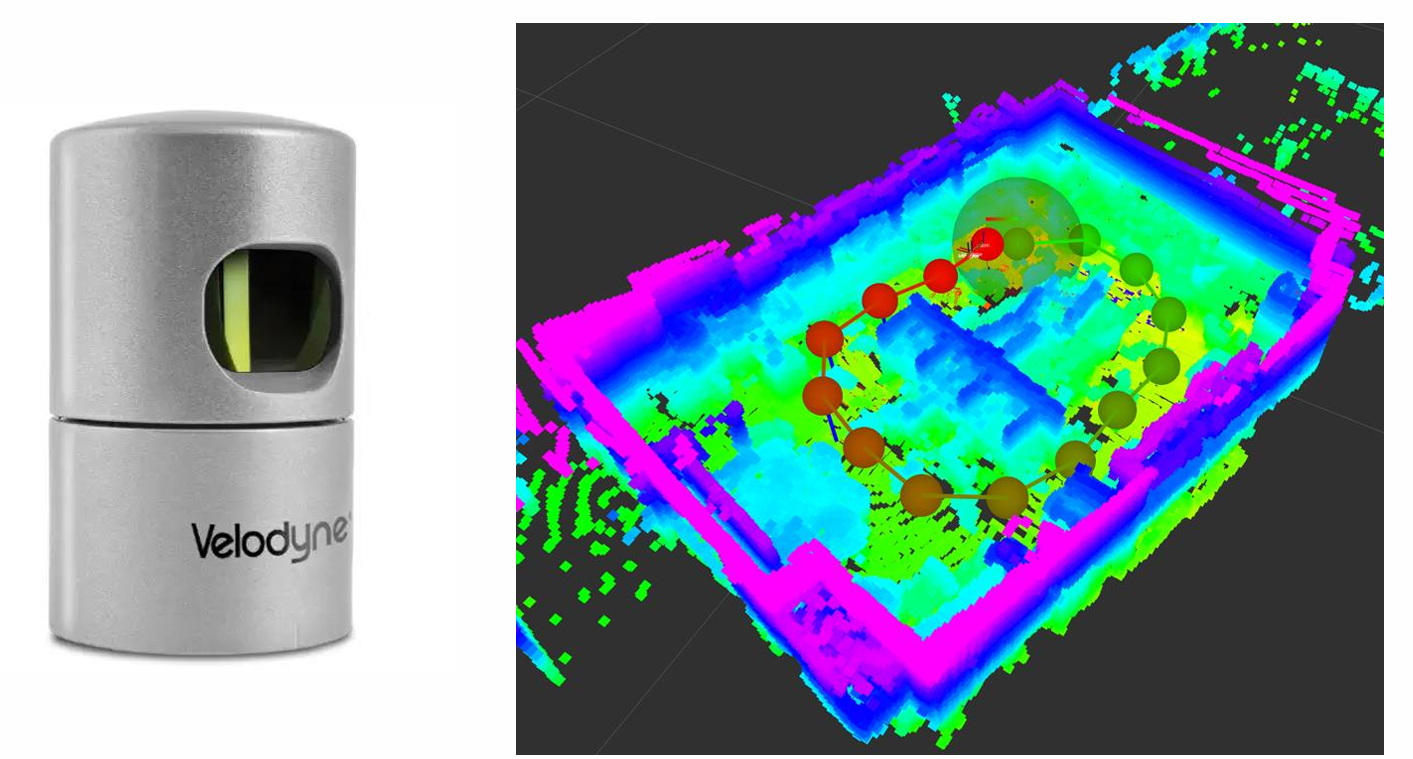

3D LiDARと3D Graph SLAMを用いて、対象空間の三次元地図を作成します。

センサ:Velodyne HDL-32E

手法 :hdl_graph_slam

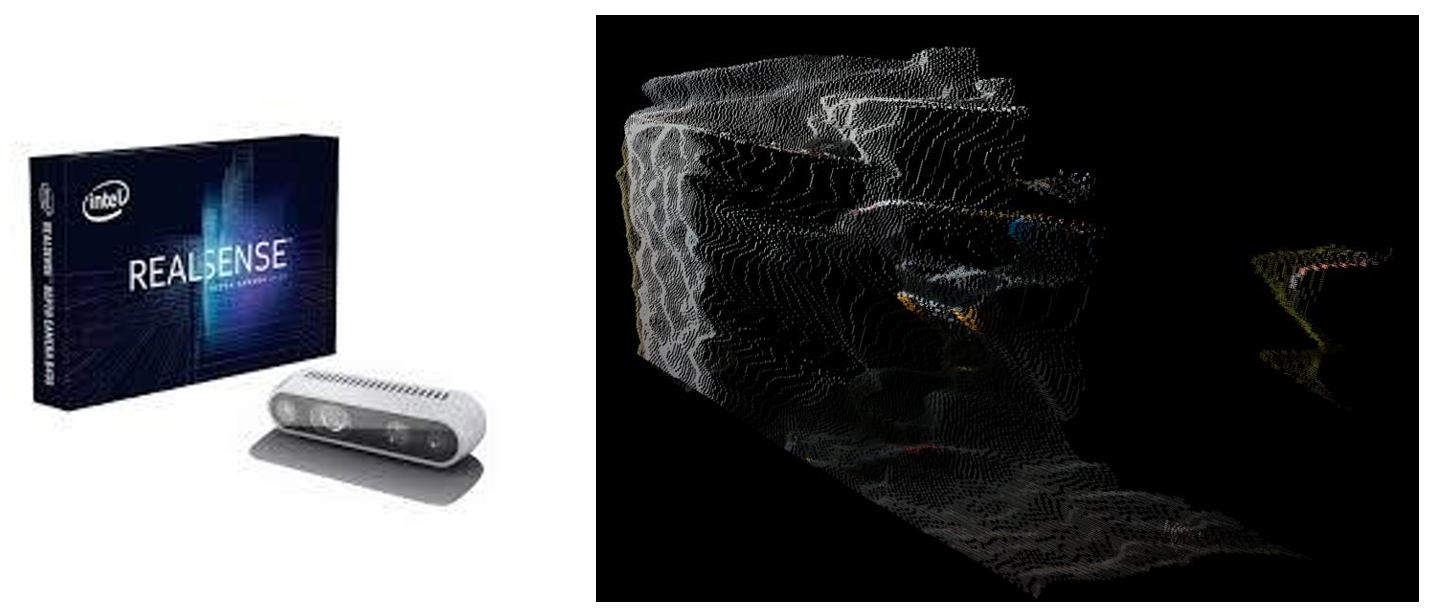

また、対象空間内に分散配置された各カメラ視点の点群データを取得します。

カメラ:Intel RealsenseDepth Camera D435

2. 位置合わせ

各カメラの視点から得られた点群データと三次元地図で位置合わせ(点群のマッチング)を行い、各カメラが空間内にどの位置・姿勢で設置されているのかを推定します。

位置合わせには、ICP(Iterative Closest Point)を用いました。

※現状のシステムでは、位置合わせを行う前に適切な初期値を与える必要があります。

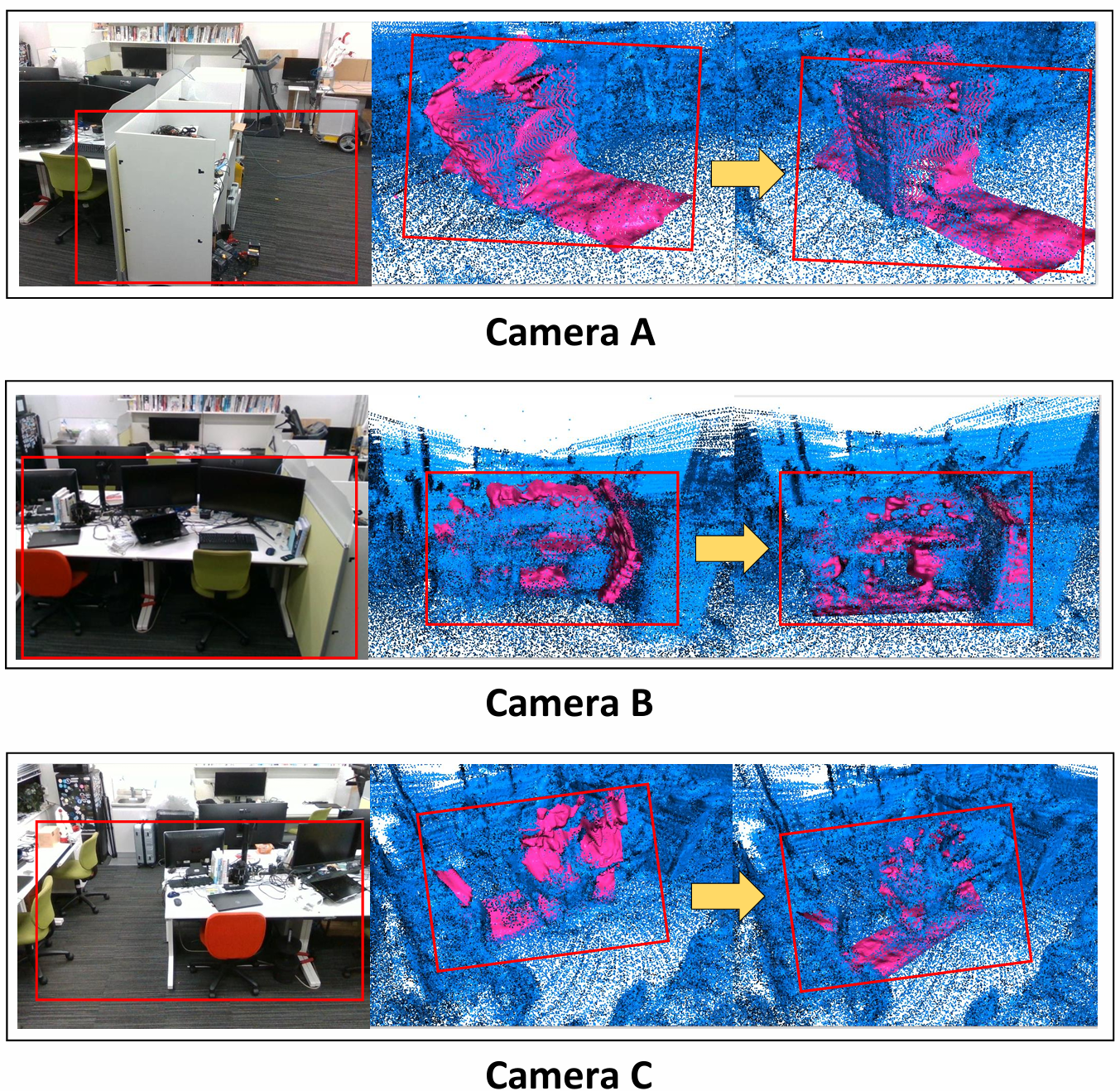

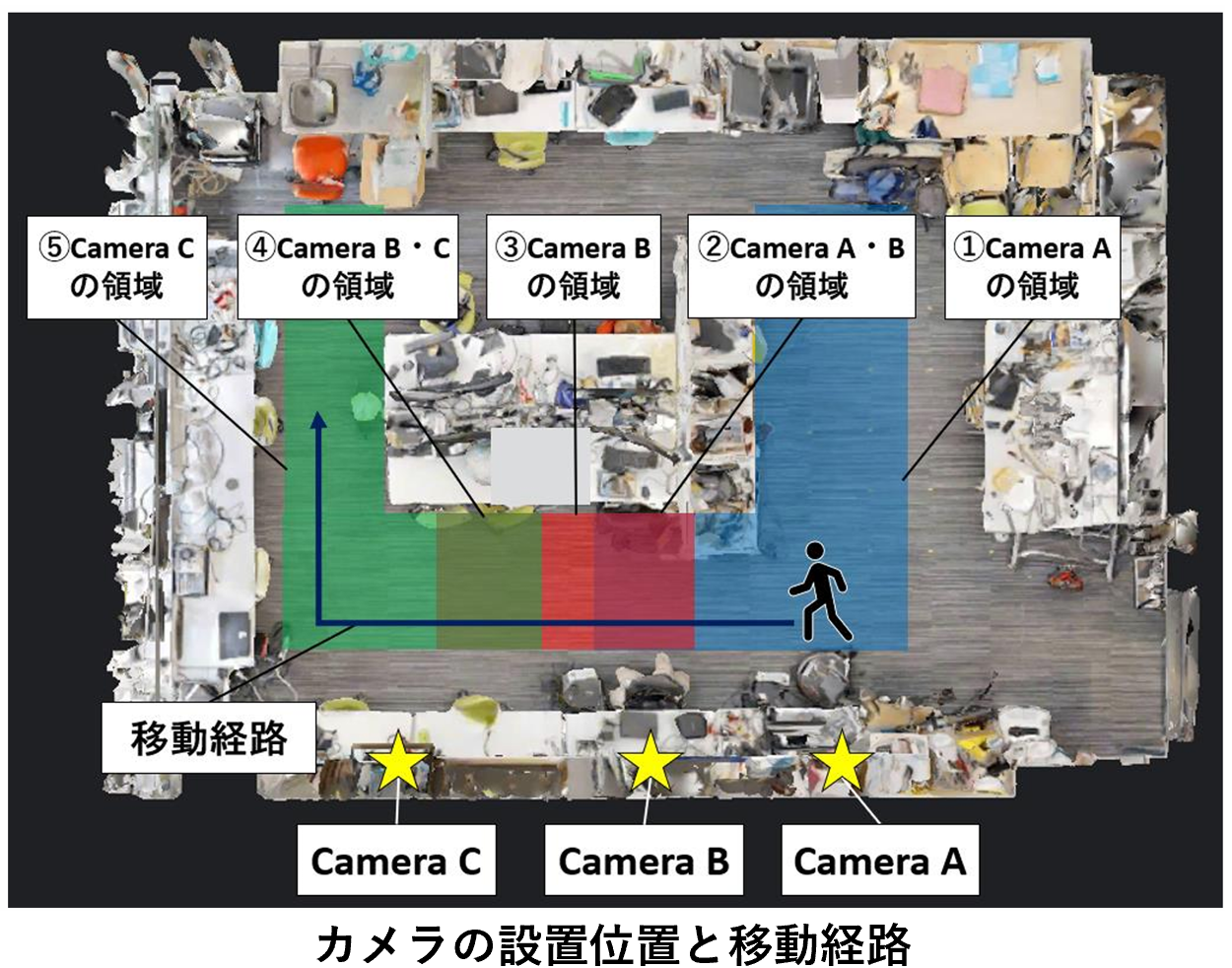

本研究では、3台のカメラを配置しました。以下に、位置合わせ前後の様子を示します。ピンクがカメラ視点の点群、青が三次元地図の点群です。また、赤い四角で囲まれた部分がそれぞれ対応する箇所を示しています。

これにより、(自動で)各カメラの位置・姿勢パラメータを取得できます。

人物追跡システム

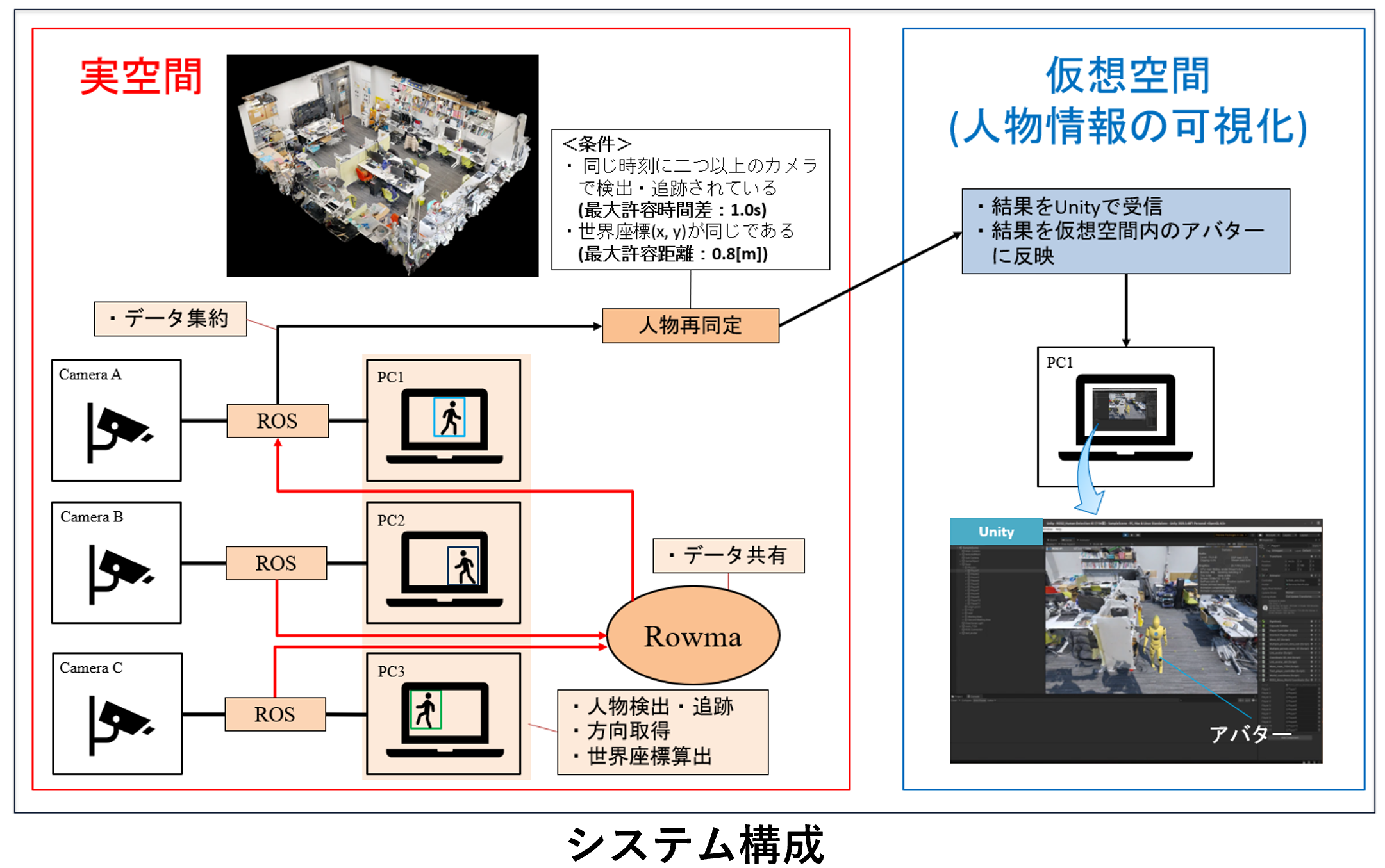

提案手法により取得したカメラの位置・姿勢パラメータの精度を検証するために、本研究では、複数のRGB-Dカメラを用いた世界座標ベースの人物追跡システムを開発しました。

本システムでは、各カメラが独立して動作するROSシステムを構成しており、Rowmaを活用することで複数のカメラでの人物追跡を実現しています。そのため、他のROSシステム(人物追跡カメラやロボットなど)の追加導入が容易で、拡張性が高いという特長があります。

実験

以下の対象空間において、提案手法により取得したカメラの位置・姿勢パラメータを用いて、複数のカメラによる人物追跡が可能であるかを検証しました。

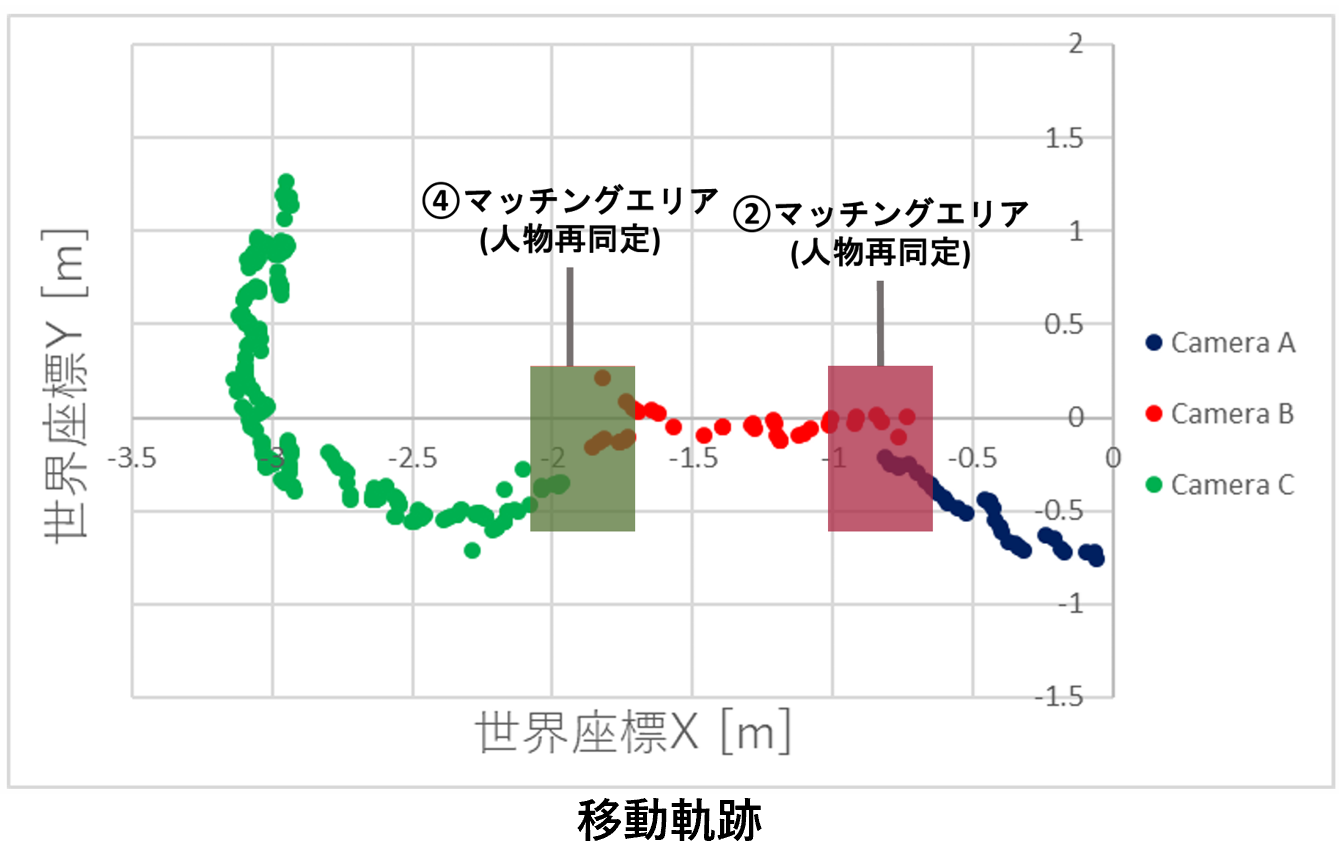

実験の結果、複数のカメラを跨いでの人物追跡が行えていました。一方で、CameraBから取得した人物位置がやや不安定でした。これは、CameraBの位置合わせ結果が他のカメラに比べて低い精度であったことが影響していると考えられます。

まとめ・今後の展望

本研究では、RGB-Dカメラと三次元地図を活用し、カメラの位置・姿勢取得作業を自動化しました。また、提案手法により取得したカメラの位置・姿勢パラメータを用いて、複数カメラによる人物追跡が可能であることを確認しました。

今後は、位置合わせの初期値設定を簡易化・自動化し、さらに本人物追跡システムを活用した空間知能化アプリケーションを開発することで、提案システムの有効性を示していきたいと考えています。

ここまでご覧いただきありがとうございました。